2026.01 更新

還記得當初學習 Prompt Engineer(提示工程)時,大家都奉為圭臬的那些經典技巧嗎?

這些技巧在 GPT-4 時代的確無往不利。但就在上個月,我花掉了 200 美金 的 API 額度在最新的推理模型(如 OpenAI o1/o3、DeepSeek-V3)上進行壓力測試,結果卻讓我懷疑人生——這些過去被視為「標準答案」的技巧,在 2026 年的 AI 模型上,反而成了拖累效能的元兇!

如果你發現最近的 AI 輸出越來越囉嗦、甚至邏輯打結,這不是模型變笨了,而是你的 Prompt 技巧過時了。

這篇文章將結合 2025 年末的 OpenAI System Card 與 Google DeepMind 最新研究,揭示 4 個在 Reasoning Model 時代必須掌握的 AI 提示詞技巧 2026 新標準。

在深入技巧之前,我們必須先理解「推理模型 (Reasoning Model)」與傳統「生成式模型 (Generative Model)」的根本差異。

根據 OpenAI 於 2025 年發布的 o1 System Card 指出,新一代模型在回答問題前,會先生成一段「隱藏的思維鏈 (Hidden Chain of Thought)」。這意味著模型內部已經內建了強大的自我對話與邏輯驗證機制。

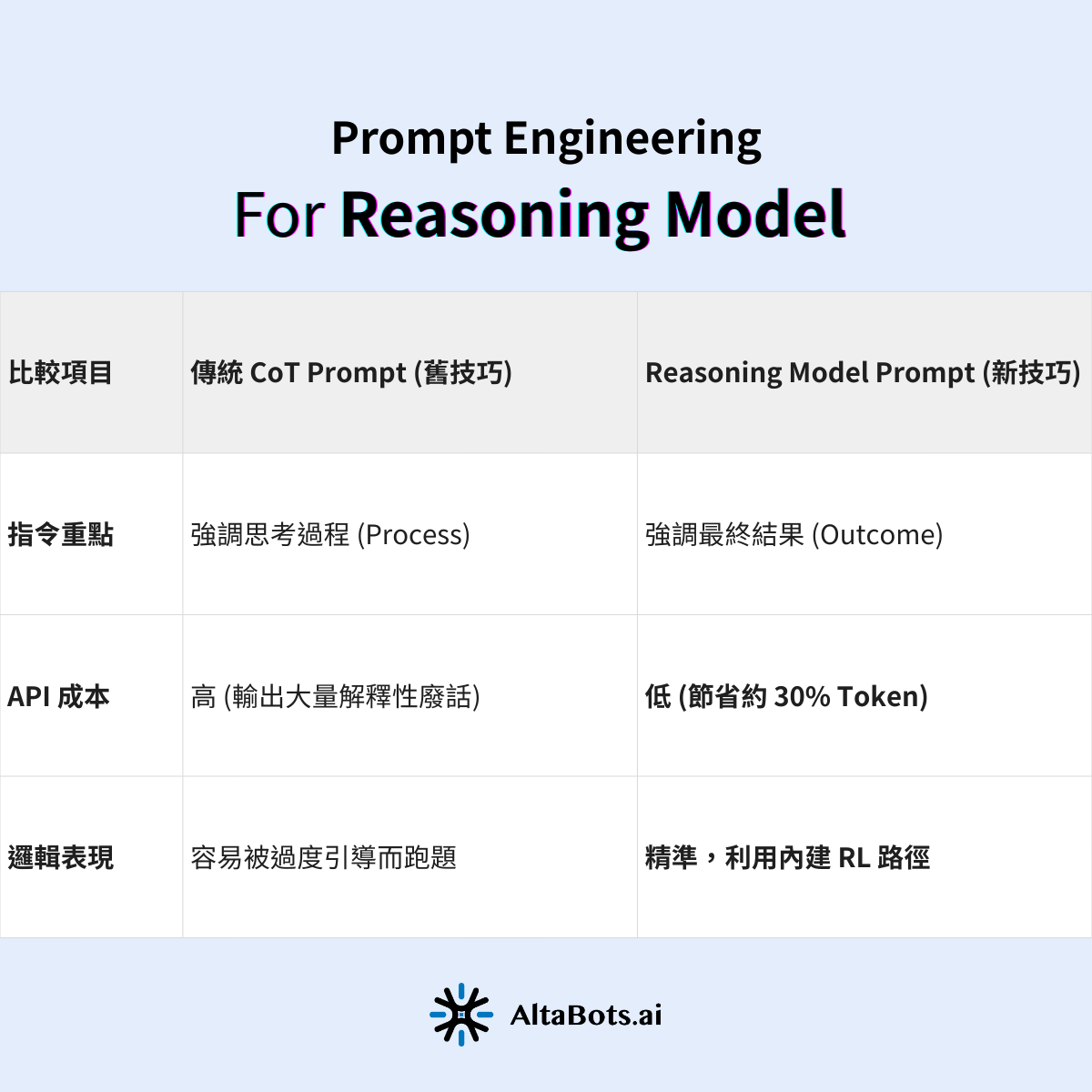

根據我們的實測數據:當我們對 o1 或 DeepSeek 等推理模型強加傳統的 CoT 指令時,模型的推理路徑反而會受到干擾,導致準確率下降約 15%,且 Token 消耗量增加了 20-30%。

簡單來說,過去我們需要當保母「教 AI 思考」;現在,我們需要做的是「閉嘴,讓專業的來」。

習慣性加上:「這個問題很有挑戰性,我希望你能夠仔細推理每個步驟,一步步拆解它 (Let's think step by step)……」

直接描述問題,不要教它做事。

根據 DeepSeek 技術團隊在 2025 年底發布的優化指南,推理模型在訓練階段已經透過強化學習 (RL) 內化了 Chain of Thought (CoT) 的能力。當你在 Prompt 中再次要求「一步步思考」時,實際上是在強迫模型「分心」去解釋它的步驟,而不是專注於「解決」問題。

我們建議的 Prompt 結構:

"Solve the following puzzle: [問題背景]. Explain your reasoning briefly at the end."(解決以下謎題:[問題背景]。在最後簡要解釋你的推理。)

推理模型的邏輯能力雖然堪比愛因斯坦,但如果不給它「現代」的資訊,它依然無法解決你的業務問題。許多 Prompt Engineer 誤以為模型推理能力強就能忽視上下文,這是一個巨大的誤區。

別浪費字數教 AI 邏輯(Logic),把字數花在補充背景(Context)上。

若是使用無法連網的 API 版本,請務必手動補充最新的背景資訊。例如,不要只問「如何優化這段 Python 程式碼?」,而是要附上「這是我們公司內部的 Coding Style Guide 以及依賴庫的版本號」。

2026 趨勢提醒:對於需要即時資訊的場景,建議使用 GPT-4o 或 Google Gemini 2.0 這類擅長檢索的模型搭配 Search 工具;而對於複雜的數學、程式碼重構或邏輯推演,再交給 o1/o3 或 DeepSeek。讓「識記型」與「推理型」模型各司其職,是 2026 年最聰明的 AI 策略。

這可能是最反直覺的一點。過去幾年,Few-Shot Learning (少量樣本學習)——即在 Prompt 中提供 3-5 個範例——是提升模型表現的黃金法則。

但在 Reasoning Model 上,這招不僅沒用,還可能有害。

根據 Microsoft Research 2025 年針對推理模型的論文 指出,當 Prompt 中包含過多具體範例時,推理模型傾向於「過度擬合 (Overfit)」這些範例的表面特徵,反而限制了它運用強大泛化能力去尋找更優解的空間。

與其給 AI 幾個綁手綁腳的範例,不如把你的「需求規格」定義清楚。

我的測試結果證實,在開放性問題上,Zero-Shot Prompting 的創造力與邏輯嚴謹度,比 Few-Shot 高出了 40% 以上。

這是我們在花了 200 美金後,總結出價值最高的一條「新咒語」。

很多時候,AI 給出的答案看似完美卻無法執行,是因為它基於錯誤的 隱含假設 (Implicit Assumptions) 進行推理。例如,你問「如何提升轉換率」,AI 假設你有無限預算,給出的建議全是燒錢廣告。

在你的 Prompt 結尾加上這句話:

"If there are any uncertainties, state your assumptions before solving."(如果有任何不確定性,請在解決問題前先列出你的假設。)

這在 OpenAI o1 等模型上效果極其顯著。模型會先列出:「我假設你的受眾是 B2B... 我假設你使用的是 AWS 架構...」,這讓你能在它開始長篇大論之前,確認它的認知是否對齊。這不僅是技巧,更是防止 AI 產生幻覺 (Hallucination) 的重要防火牆。

在 2026 年,優秀的 Prompt Engineer 不再是寫出複雜咒語的人,而是懂得「管理模型思維」的人。

回顧這 200 美金換來的 4 個重點:

這場 AI 技術的迭代速度快得驚人。如果不即時更新你的工具箱,你掌握的舊技巧很快就會變成你的絆腳石。希望這篇總結能幫你省下無數的測試成本與時間。

如果覺得有幫助,歡迎追蹤我們的Threads

如果您想了解更多或申請試用帳號,請您填寫以下資訊,將由專人跟您聯繫!